Il mondo dell’intelligenza artificiale continua a evolversi rapidamente, portando con sé sia importanti innovazioni sia sfide legate alla sicurezza e alla privacy. Due recenti novità testimoniano questa doppia faccia del progresso: da un lato, una criticità emersa riguardo alla protezione dei dati nelle conversazioni con ChatGPT; dall’altro, un’interessante trasformazione dei chatbot che diventano sempre più social, favorendo la condivisione e l’interazione tra utenti. Questi sviluppi mostrano come l’AI stia sempre più integrandosi nella vita quotidiana, aprendo nuove strade ma richiedendo anche attenzione e responsabilità.

ChatGPT a rischio privacy: oltre 100.000 conversazioni esposte su Google, OpenAI interviene

OpenAI, l’azienda dietro ChatGPT, si è sempre presentata come paladina della sicurezza e della privacy degli utenti. Tuttavia, una recente scoperta ha sollevato un serio campanello d’allarme: più di 100.000 conversazioni tra il chatbot e vari utenti sono apparse pubblicamente indicizzate su Google, accessibili con una semplice ricerca. Non si tratta solo di qualche frammento dimenticato: si parla di intere sessioni di chat, spesso contenenti dettagli sensibili, personali o riservati.

La notizia è emersa grazie a una segnalazione di TechCrunch, che ha evidenziato come sia bastato un banale comando di ricerca per accedere a un archivio involontario di interazioni. A complicare la questione, molte di queste conversazioni sono finite anche nella Wayback Machine di Archive.org, dimostrando che il problema non si limitava al solo motore di ricerca. Il Direttore di Wayback Machine, Mark Graham, ha spiegato che OpenAI non aveva mai chiesto formalmente la rimozione di questi contenuti.

“Se ci avessero contattato ufficialmente, avremmo rimosso gli URL. Ma non abbiamo ricevuto alcuna richiesta, quindi non siamo intervenuti”, ha affermato. Una mancanza che solleva dubbi sulla gestione della sicurezza da parte dell’azienda, soprattutto in un’epoca in cui la fiducia verso le tecnologie AI è tanto alta quanto fragile. In risposta alla diffusione mediatica del caso, OpenAI ha confermato di aver disattivato la funzione di condivisione delle conversazioni e di aver richiesto la deindicizzazione delle URL da Google e Bing.

La società ha giustificato l’accaduto parlando di un “test sperimentale”, condotto per permettere la facile condivisione di conversazioni pubbliche. Tuttavia, il test si è rivelato un boomerang: nessun avviso era stato fornito agli utenti, che si sono trovati esposti senza saperlo. Il danno è doppio. Da un lato c’è l’aspetto tecnico — la vulnerabilità concreta —, dall’altro quello della fiducia: molti utenti utilizzano ChatGPT per scopi sensibili, convinti che le loro conversazioni rimangano riservate.

Ma l’incidente dimostra che le precauzioni non sono state sufficienti, e che lo strumento, se mal configurato, può diventare una fonte di esposizione non intenzionale. OpenAI ha ammesso l’errore, affermando che il sistema “ha creato molte opportunità per condividere accidentalmente dati che gli utenti non intendevano divulgare”. Ma è un’ammissione che arriva dopo che il danno è già stato fatto.

I chatbot ora diventano social: la novità di Character.AI

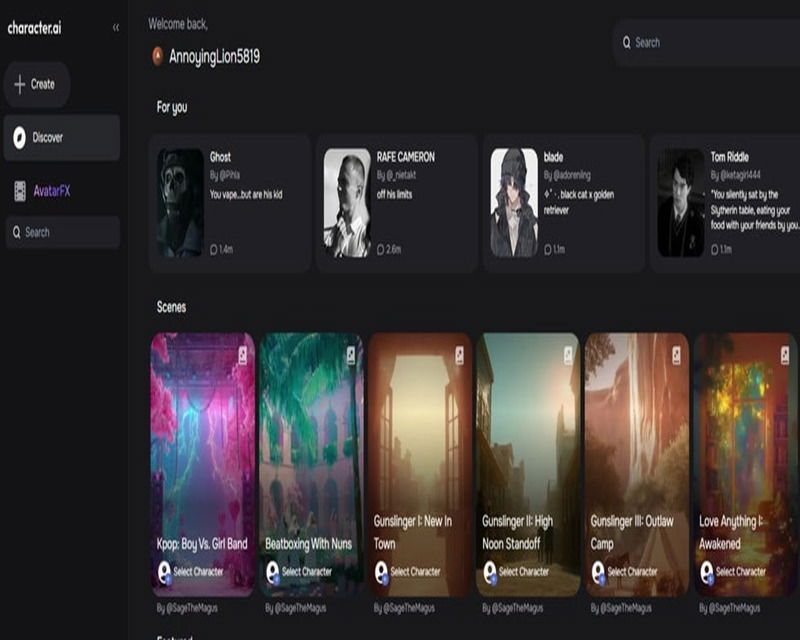

Passando a una novità più lieta pur restando nello stesso settore, Character.AI sta rivoluzionando l’interazione con l’intelligenza artificiale introducendo un feed social all’interno della sua app mobile, una novità che trasforma l’esperienza d’uso da interazione privata a vera e propria condivisione pubblica.

Gli utenti possono ora postare estratti delle conversazioni più divertenti o interessanti con i chatbot, condividere immagini generate dall’AI e partecipare a dibattiti in livestream tra diversi personaggi virtuali, rendendo l’app una piazza digitale dove la creatività e l’intrattenimento sono protagonisti. A supporto di questa svolta, è stato introdotto AvtarFX, un modello generativo video che permette di creare brevi filmati partendo da testi o immagini, ampliando ulteriormente le possibilità espressive degli utenti.

Secondo Karandeep Singh, CEO di Character.AI, questa evoluzione cancella il confine tra creatori e fruitori di contenuti, dando vita a una community dinamica e partecipativa. Questa iniziativa si inserisce in un più ampio movimento nel settore AI, che punta a integrare funzionalità social per aumentare coinvolgimento e condivisione, un passo importante verso un futuro in cui le intelligenze artificiali saranno parte integrante delle nostre reti sociali digitali.